Die Digitalisierung begann mit der zunehmenden Verfügbarkeit von Daten – und dem Wunsch, damit operativ zu steuern. Auf Dashboards folgten Diagnosen und Prognosen und schließlich Assistenzsysteme, die Empfehlungen geben. Doch ein KI-System in produktiver Umgebung bereitzustellen, bedeutet weit mehr, als „nur“ Algorithmen zu entwickeln oder zu trainieren. Nachdem im ersten Teil einige theoretische Grundlagen erläutert und erste praktische Anwendungen aufgezeigt wurden, geht es nun darum, welche Schlüsse für den zukünftigen Einsatz von KI auf der Schiene gezogen werden können.

Der Aufbau verlässlicher Schnittstellen, Datenarchitekturen und Plattformen ist entscheidend – genauso wie die Einbindung in die Organisation und eine kontinuierliche Kommunikation. Aus der Erfahrung heraus lassen sich sieben zentrale Learnings formulieren:

1. KI ist der Kern, das Drumherum ist entscheiden

Während intelligente Algorithmen und die von ihnen genutzten Daten im Fokus der meisten Diskussionen um KI-Anwendungen stehen, droht ein entscheidender Aspekt aus dem Blickfeld zu geraten: die (Software-)Integration. Denn ohne die Integration in bestehende Anwendungen vermögen die wenigsten KI-Lösungen einen praktischen Nutzen zu liefern.

Dies liegt einerseits darin begründet, dass KI im Live-Betrieb in der Regel auch Live-Daten benötigt. Die Bereitstellung dieser Daten erfolgt über Datenverbindungen, Schnittstellen, Pipelines etc. Jede dieser Datenanbindungen enthält eine ganze Reihe von Fehlerquellen, wie Fehler in Freischaltungen beziehungsweise Zugriffsberechtigungskonzepten oder Datenformaten, und erfordert einen initialen Aufwand für die Entwicklung oder Einrichtung der Schnittstelle sowie eine nahezu kontinuierliche Überwachung und Pflege. Schon allein, um die häufig erscheinenden Sicherheitsupdates einzupflegen.

Doch mit der Datenanbindung ist es noch nicht getan. KI-Anwendungen erfordern – wie alle Anwendungen – eine Infrastruktur, auf der sie laufen. Diese Infrastruktur, sei es in der Cloud oder On-Prem, also im eigenen Rechenzentrum, muss ebenfalls konzipiert, aufgebaut und betriebsgeführt werden.

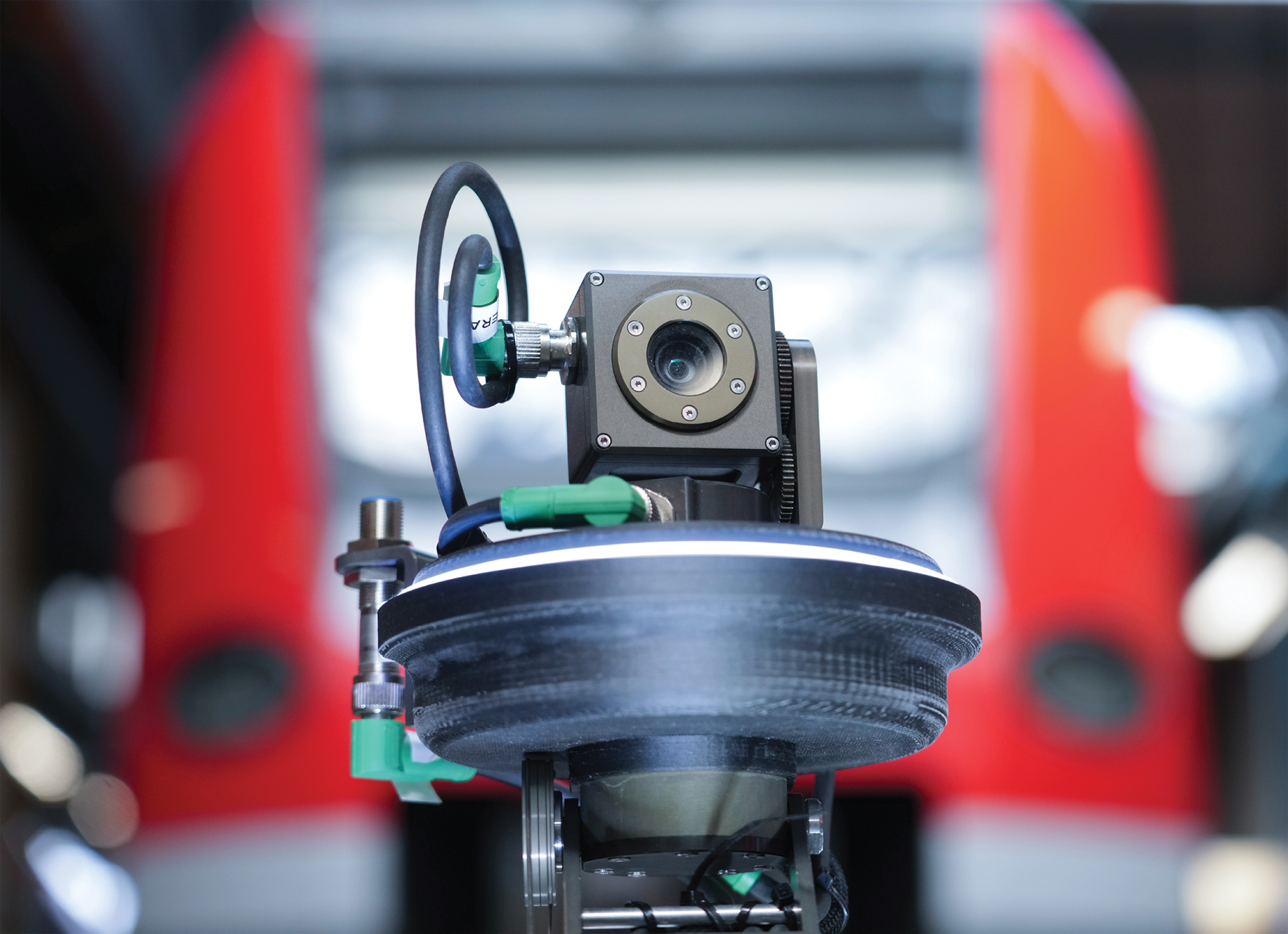

Und schließlich gilt es, die Outputs der KI-Anwendungen nutzbar zu machen. Dies erfordert zumindest eine Benutzeroberfläche, idealerweise eine, mit der die User gut und gerne arbeiten können. Oder noch besser, eine Datenintegration in die operativen Prozesse oder IT-Verfahren. Wie im Beispiel der Graffiti-Erkennung, wo automatisch ein Reinigungsauftrag generiert wird, wenn ein Graffito auf einem Zug erkannt wird. Für diese Datenintegration gilt das Gleiche wie für die Datenversorgung, nur das noch der Aufwand für die Anpassungen an den die KI-Ergebnisse konsumierenden Verfahren hinzu kommt. Damit liegt die größte Herausforderung nicht im Algorithmus, sondern im Transfer.

2. Fundament für stabile KI auch beim Staffing berücksichtigen

Wenn man anerkennt, dass die Basisarbeit, das sind die Schnittstellen, Integration, Infrastrukturbetrieb etc., in der Regel deutlich mehr Ressourcen als die Entwicklung des KI-Kerns bindet, dann wird offensichtlich, dass dies auch im Personalansatz entsprechend abgebildet werden sollte. Um es plastisch zu beschreiben: Ein Profi-Rennwagen wird von einer Person gefahren und von einem ganzen Team gewartet. Genauso brauchen wir einige sehr fähige Algorithmenentwickler*innen, KI-Ingenieur*innen oder Data Scientists für den KI-Kern von Anwendungen und ein großes Team von Softwareentwickler*innen und System-Administrator*innen, das die Basisarbeit übernimmt. Dies gilt sowohl währen der Aufbauphase als auch während der Betriebsführungsphase einer KI-Anwendung.

Fehlen unterstützende Rollen für die Basisarbeit, so übernehmen in der Praxis häufig die Mitarbeitenden, die den KI-Kern entwickeln sollen, diese Aufgaben mit. Dies führt zu Überlastung, Frustration und nicht-standardkonformen Lösungen, weil zusätzliche Aufgaben, welche teilweise außerhalb des Qualifikationsprofils liegen, übernommen werden müssen. Ganz zu schweigen davon, dass Projekte dann auch teurer werden, wenn hochbezahlte Rollenträger einen relevanten Teil ihrer Arbeitszeit für IT-administrative Tätigkeiten aufwenden müssen. Kommt Fluktuation aufgrund von Überlastung und/oder Frustration hinzu, wird es noch teurer und Projektverzögerungen sind vorprogrammiert.

3. Legacy-Systeme bleiben Realität

Während die zuvor beschriebenen Herausforderungen für auf der grünen Wiese komplett neuaufgebaute Systeme bereits signifikant sind, so wird das Problem bei der Arbeit mit Legacy, also Bestandssystemen, noch gravierender. Dennoch wird es auf absehbare Zeit sowohl bei der Eisenbahn als auch in den meisten anderen etablierten Industrien zur Realität dazu gehören, dass Bestandssysteme die Regel sind. Und in diesen Bestandssystemen stecken häufig die benötigten Daten für die KI-Anwendungen.

Um wirksam zu werden, müssen die KI-Anwendungen mit diesen Bestandssystemen sogar interagieren. Die Komplikation dabei ist, dass Schnittstellen bei Bestandssystemen teilweise nur unvollständig dokumentiert sind und teilweise Datenfelder in der Praxis abweichend von der Dokumentation genutzt werden. Hinzu kommt, dass Bestandssysteme teilweise an die Grenzen ihrer Leistungsfähigkeit stoßen, wenn sie zusätzlich zu ihren eigentlichen Aufgaben größere Mengen von Daten senden und/oder empfangen und verarbeiten sollen. Und schließlich ist der Code von Bestandssystemen oft nicht gut dokumentiert, teilweise sind sie auch in Programmiersprachen entwickelt, die nur noch von wenigen Entwicklern beherrscht werden.

4. Datenqualität ist keine Selbstverständlichkeit

Falsche, ungenaue oder unvollständige Daten führen nahezu unweigerlich zu falschen Ergebnissen von KI-Anwendungen. Dies lässt sich zum Teil, jedoch meist nicht vollständig durch zusätzliche Prüfalgorithmen für die genutzten Daten abmildern. Falsche Ergebnisse führen potenziell zu falschen Entscheidungen. Je nach Einsatzgebiet kann dies zu erheblichen Konsequenzen führen, so dass risiko-abhängig geeignete Sicherheitsmechanismen bei der Konzeption und Entwicklung von KI-Anwendungen mitgedacht werden müssen.

Schlimmer ist in der Langfristperspektive jedoch: Falsche Ergebnisse zerstören das Vertrauen in die KI-Anwendungen. Hannah Fry nennt dieses Phänomen Algorithmen-Aversion. Sie beschreibt damit, dass Menschen dazu neigen, einer KI-Anwendung erst übertrieben große Erwartungen entgegenzubringen und dann das Vertrauen vollständig zu verlieren, sobald sie feststellen, dass die KI-Anwendung einmal einen Fehler gemacht hat.

Vor dem Hintergrund der Vielzahl von Fehlerquellen bei der Datenversorgung, der häufig gegebenen Abhängigkeit von Legacy-Systemen und dem Umstand, dass die genutzten Daten häufig – zumindest teilweise – aus manuellen Dateneingabeprozessen mit einer relativ hohen Fehleranfälligkeit resultieren, ist neben den bereits genannten technischen Vorkehrungen zum Umgang mit falschen, ungenauen oder unvollständigen Daten und Sicherheitsmechanismen auch die Sensibilisierung der User für das Thema Datenqualität und ihrer Folgen unerlässlich. Dies betrifft sowohl die User, welche manuell Daten erfassen, als auch die User, die mit den Ergebnissen der KI-Anwendungen arbeiten.

5. Intelligente Systeme erhöhen auch die Abhängigkeit

Dies wird als das Automatisierungsparadox bezeichnet. Es besagt, dass mit wachsender Verbreitung intelligenter Systeme die Abhängigkeit von deren Verfügbarkeit und Korrektheit steigt. Dies ist bei der Formulierung von Anforderungen an KI-Systeme und insbesondere bei der Konzeption des technischen Fundaments zu berücksichtigen. Es unterstreicht die Bedeutung der bereits genannten Basisarbeit. Gleichzeitig steigen die Kosten für KI-Anwendungen mit den wachsenden Anforderungen an Verfügbarkeit und Integrität.

Und da kein System einhundert Prozent unfehlbar und unangreifbar ist, gilt es parallel jeweils zu prüfen, ob ein Rückfallsystem aus KI-unabhängiger Technik und für deren Nutzung qualifizierten Personalen vorgehalten werden muss. Dies ist ein Thema, welches angesichts der veränderten Anforderungen an die Resilienz der Eisenbahn als Rückgrat der Volkswirtschaft und militärisch relevantes Transportmittel in der aktuellen sicherheitspolitischen Lage an Bedeutung gewinnt.

6. KI-Einsatz ist in von Wettbewerb geprägten Umfeldern alternativlos

Die Einsicht, dass Menschen nicht von KI, sondern von anderen Menschen, die KI benutzen, von Arbeitsplätzen verdrängt werden, ist fast schon zum Aphorismus geworden. Dahinter liegt die dem Organisationsforscher W. Edwards Deming zugeschriebene Annahme, dass selbst ein schlechtes System einer gut arbeitenden Person stets über-legen ist.

Die Gründe dafür liegen einerseits darin, dass die menschliche Leistungsfähigkeit natürlichen Schwankungen unterliegt. Ein System setzt Standards und zieht damit eine untere Grenze für die Leistungs-fähigkeit ein. Zum Beispiel, indem durch Prozesse und Checklisten Fehler vermieden werden.

Andererseits kann ein stabil laufendes System kontinuierlich verbessert werden. Im Kontext des Lean Management wurden dazu zahlreiche Methoden, wie zum Beispiel Six Sigma, entwickelt. So kann die durch das System eingezogene, untere Grenze der Leistungsfähigkeit im Zeitablauf immer weiter angehoben werden. KI-Anwendungen stellen in diesem Kontext einfach nur eine weitere Ausbaustufe und ein neues Werkzeug im Prozess dar. Das Potenzial von KI-Anwendungen als Werkzeug in Prozessen ist enorm.

7. Auf die Menschen und das Ökosystem kommt es an

Wirklich erfolgreiche KI-Anwendungen funktionieren, weil sie von Menschen in ihrem jeweiligem Ökosystem akzeptiert und genutzt werden. Das heißt, es kommt für den Erfolg einer KI-Anwendung nicht auf den Algorithmus allein, sondern auf das ganzen Ökosystem an. Dazu gehören die Organisation und ihre Kultur, die Rollenprofile, ein agiles Mindset und – ganz wesentlich – die Menschen und deren Qualifikation. Schulungen sollten neben dem Bewusstsein für Datenqualität auch ein Verständnis der genutzten Technologien und für deren Limitationen schaffen.

Damit ist nicht gemeint, dass künftig jeder User in der Lage sein soll, von Hand ein neuronales Netz zu programmieren. Wer jedoch zum Beispiel ein KI-Verfahren, welches auf einem neuronalen Netz basiert, nutzt, sollte wissen, dass ein solches neuronales Netz darin steckt, welche Daten für das Training des neuronalen Netzes genutzt wurden, wie die Qualität sichergestellt wird, wie die erwartete Genauigkeit der Ergebnisse ist, wie diese erwartete Genauigkeit zu interpretieren ist und in welchen Situationen die KI-Anwendung nicht genutzt werden kann. Auch für etwaige Verzerrungen, auch Bias genannt, sind die User zu sensibilisieren.

Ziel muss sein, dass die User den Ergebnissen vertrauen, weil sie verstehen, wie sie zustande kommen und sie die Grenzen der Methoden einschätzen können. Dies wird teilweise auch durch den EU-AI-Act gefordert und führt zum letzten Bestandteil des Öko-systems: dem regulatorischen Umfeld. Hier bestehen inzwischen zahlreiche Anforderungen zu Governance und IT-Sicherheit sowie zu Datenschutz und Ethik.

Für die Eisenbahn bestehen zusätzliche Anforderungen seitens des Eisenbahn-Bundesamtes und, insbesondere im Fall der DB InfraGO, der Bundesnetzagentur. Compliance mit all diesen Anforderungen schafft Rechtssicherheit und vermeidet Reputations- und Haftungsrisiken. Zusammenfassend bestätigt die Erfahrung die oft postulierte Daumenregel, dass IT- und Change-Management in KI- beziehungsweise Datenprojekten 95 Prozent der Ressourcen beanspruchen, während nur 5 Prozent auf die Modell- und Algorithmenentwicklung entfallen.

Fazit

Das Feld der KI ist bunt und bringt einen gut gefüllten Methodenkoffer mit. Ob Heuristik, mathematische Optimierung, klassisches maschinelles Lernen, Deep Reinforcement Learning oder GenAI – unabhängig vom Hype kann das Potenzial von KI gehoben werden, wenn passgenaue KI-Methoden für spezifische Herausforderungen genutzt und Ansätze intelligent verknüpft werden. Nicht jede KI-Methode eignet sich jedoch gleichermaßen für alle Aufgaben. Daher lohnt es sich, wenn von KI die Rede ist nachzufragen, welche Technologie tatsächlich dahintersteht.

KI-gestützte Systeme sind kein Selbstzweck – sie müssen als verlässliche Werkzeuge in den Alltag integriert werden. Der Aufbau von KI-Systemen muss daher einhergehen mit dem Aufbau verlässlicher Systeme drumherum sowie einer sinnvollen Integration in die operativen Prozesse oder IT-Verfahren. Denn KI-Lösungen stehen selten allein, sie sind das Dach auf einem Kartenhaus von Datenplattformen, Schnittstellen und Software-Pipelines. Datenqualität bleibt die unabdingbare Basis. Und auch Wartung & Betrieb aller Systembausteine muss sichergestellt werden.

Erfolg von KI im Bahnbetrieb entsteht nicht durch die „smarte“ KI-Anwendung allein, sondern durch das Zusammenspiel von Technik, Prozessen, Menschen und Kultur – und auch die Anforderungen von Regulierung und Governance sind zu berücksichtigen. Schließlich geht es darum Vertrauen und damit Akzeptanz zu schaffen, während Algorithmen-Aversion vermieden wird. Daher sind Transparenz, Schulung und Change-Management sowie kontinuierlicher Dialog mit den Usern wesentliche Bausteine für KI-Projekte. Wenn all diese Elemente zusammenspielen, entfaltet KI ihr volles Potenzial zur Optimierung von Pünktlichkeit, Verfügbarkeit und Wirtschaftlichkeit – über den Hype hinaus.

Lesen Sie auch:

Artikel als PDF laden